Die kognitive Wende in der Architektur. Die Erkundung der Interaktion von Denken, Raum und Design

In den 1960er-Jahren waren Lernautomaten der Treibstoff, der eine revolutionäre Welle in der Pädagogik entfachte, die bis heute anhält. Was als kybernetisches Experiment in Denkfabriken und Forschungsinstitutionen begann, breitete sich bald weltweit aus.

Die Vorstellung, intelligente Maschinen könnten den Lernprozess automatisieren, war ein globales Phänomen, das insbesondere in Deutschland und den USA eine dynamische Entwicklung nahm und darüber hinaus auch Architektur und Design beeinflusste. Deutschland, mit seiner tief verankerten Tradition humanistischer Bildung, traf hier auf eine technologische Avantgarde. Die Idee, dass Maschinen den Unterricht effizienter gestalten könnten, rüttelte an den Grundpfeilern eines gesellschaftlichen Bildungsideals, das auf Ganzheitlichkeit und sozialer Reform beruhte.[1]

Helmar Frank, ein ehemaliger Gymnasiallehrer und Schüler des Philosophen Max Bense, war eine Schlüsselfigur dieser Entwicklung. Sein 1969 publiziertes Buch Kybernetische Grundlagen der Pädagogik[2] brachte frischen technologischen Wind in die verstaubte Bildungslandschaft der deutschen Nachkriegszeit. Für Frank war die Kybernetik mehr als eine neue Form der Mathematik – sie war eine Art Universalvision, die darauf abzielte, die gesamte Gesellschaft neu zu organisieren. In Lernautomaten sah er eine vielversprechende Methode, um den Unterricht aus den Fesseln traditioneller, langsamer Lehrmethoden zu befreien. Bildung sollte nicht länger dem gemächlichen Takt der Geisteswissenschaften folgen, sondern dem schnellen Puls der Maschinen. Der provokante Untertitel seines Buches richtete sich daher auch direkt an „Analytiker, Planer und Techniker“, was auf einen radikalen Bruch mit der klassischen Pädagogik hindeutete: Wissen sollte systematisch aufgeteilt und maschinell vermittelt werden.

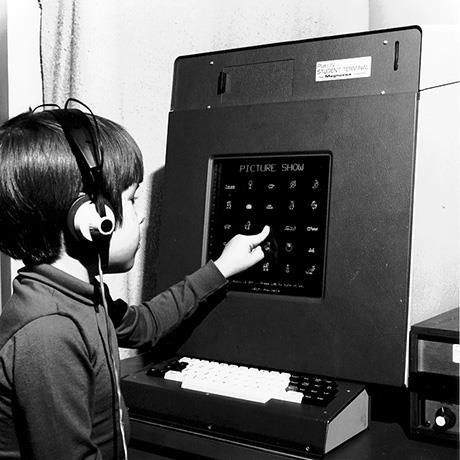

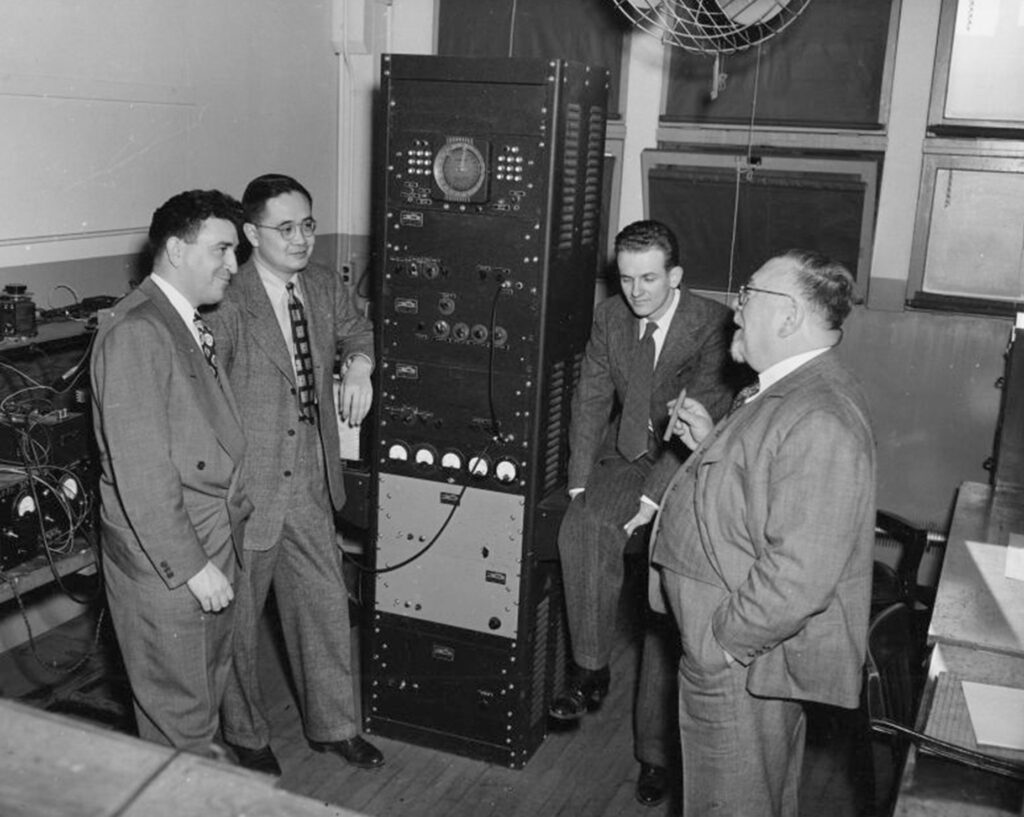

Parallel dazu, auf der anderen Seite des Atlantiks, sorgte der „Sputnik-Schock“ von 1957 für einen radikalen Umbruch in der amerikanischen Bildungslandschaft.[3] Der Wettlauf ins All hatte einen bildungspolitischen Innovationsschub entfacht, getrieben von der Angst, technologisch hinter die Sowjetunion zurückzufallen. Die USA reagierten mit einer massiven Aufrüstung ihres Bildungssystems. Sogenannte Teaching Machines, wie beispielsweise das überaus populäre PLATO System (Programmed Logic for Automated Teaching Operations), wurden eingeführt, um den Lernstoff in standardisierte, kleine Einheiten – sogenannte Lernquanten – zu zerlegen.[4] Das Ziel war maximale Effizienz, nicht tiefe Erkenntnis. Hier wurde Wissen industriell verarbeitet, wie ein Produkt, das am Fließband sequenziell konsumiert werden sollte. Die Automatisierung des Lehrens ging also Hand in Hand mit der Automatisierung des Lernens: ein störungsfreier Regelkreis aus Hardware, Software und User. In dieser Phase veränderte sich das Verhältnis von Mensch, Raum und Maschine fundamental. Es wurde ein neues Kapitel der Pädagogik aufgeschlagen, das bis heute nachwirkt.

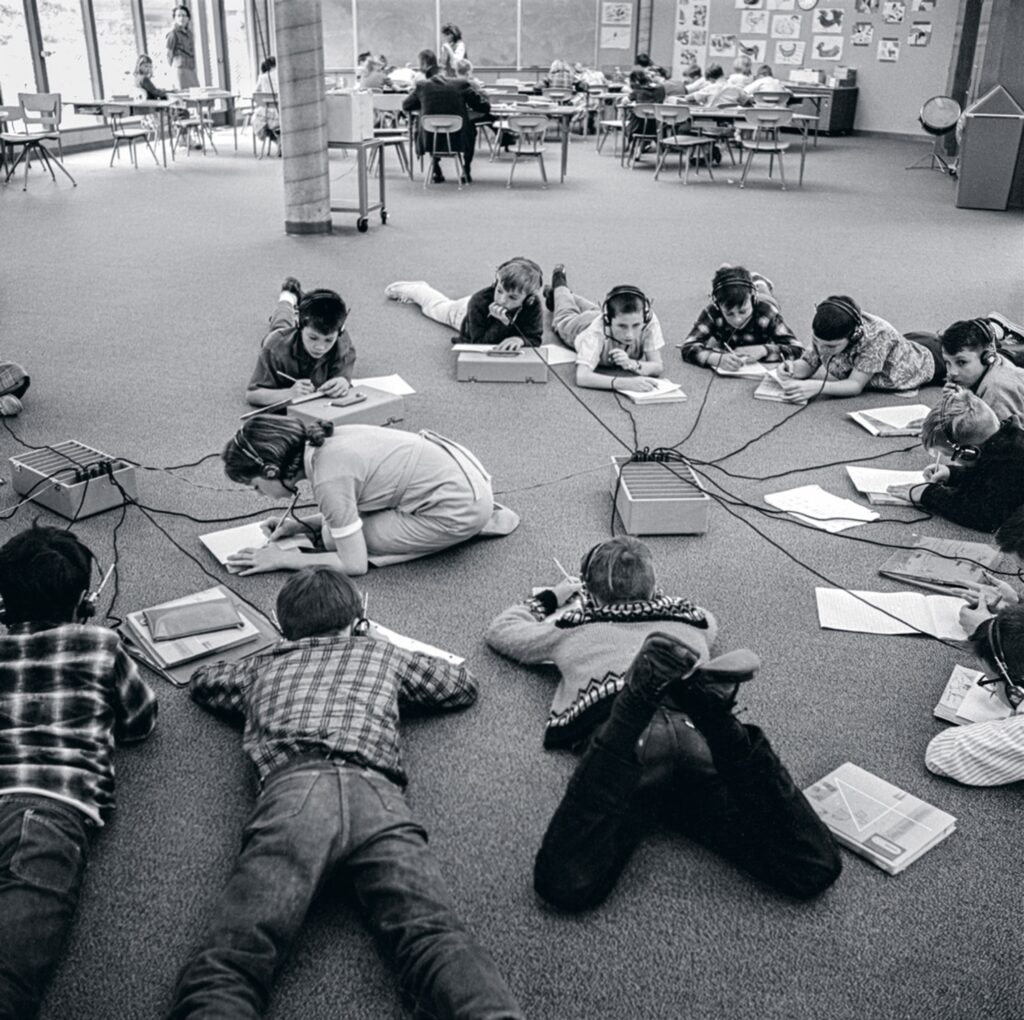

Während man in Deutschland an der präzisen Instruktionslogik von Lehrmaschinen feilte, dachte man in den USA weit größer. Hier führte der Kognitionspsychologe George A. Miller einen radikalen Paradigmenwechsel herbei. In seinem 1967 erschienenen Essay „Some psychological perspectives on the year 2000” entwarf Miller ein Szenario, das die Bildungslandschaft seiner Zeit auf den Kopf stellte: Ein Klassenzimmer, unterteilt in kleine, semi-isolierte Kabinen, ausgestattet mit Kopfhörern, Tastaturen, Bildschirmen und einem „Lichtstift“, alles vernetzt mit einem zentralen Computer. „Der Schüler kommuniziert durch die Tastatur oder zeigt mit dem Lichtstift auf den Bildschirm; der Computer antwortet mit Sprache oder visuellen Darstellungen“, beschrieb Miller. Was nach Science-Fiction klang, sah Miller als greifbare Zukunft: Lernen sollte individuell, flexibel und interaktiv werden. Ohne die starren Grenzen des traditionellen Unterrichts könnten die Schüler*innen in ihrem eigenen Tempo lernen.

„Für viele ist der Computer ein Synonym für mechanische Entfremdung“, gab Miller zu. Doch zugleich ermögliche der Computer „eine individuelle Aufmerksamkeit, wie sie nur ein Privatlehrer bieten könnte“.[5] Hier zeigte sich die Verknüpfung von Individualismusideal, digitaler Technologie und Bildungskapitalismus – ein Triumvirat der frühen Maschinenpädagogik. Dieses Konzept propagierte eine operative Stärkung des Individuums durch technologische Aufrüstung und versprach damit nicht nur höhere Effizienz, sondern auch eine neue Form der demokratischen Gemeinschaft.

Millers Ansatz markierte eine Revolution im Bildungsdenken: Weg von der behavioristischen Kontrolle hin zur kognitiven Interaktion, die das Innenleben des Denkens in den Fokus rückte. Diese „kognitive Wende“ stellte das dominierende Paradigma des Behaviorismus, wie es B. F. Skinner propagierte, radikal in Frage.[6] Skinner sah den Menschen als „Black Box“, deren Verhalten allein durch äußere Reize erklärbar sei.

Die Kognitionswissenschaft hingegen lenkte den Blick auf die inneren mentalen Prozesse. Miller, unterstützt von Noam Chomsky, argumentierte, dass komplexes Lernen nur durch das Studium der kognitiven Vorgänge verstanden werden könne. Es war eine Wiederentdeckung des Denkens – und des Raums. Miller lässt sich, auch wenn solche Vergleiche immer etwas hinken, durchaus in einem Atemzug mit dem Architekten und Stadtplaner Kevin Lynch nennen. Lynch erforschte in den 1960er-Jahren am MIT empirische Methoden zur Stadtwahrnehmung und gilt bis heute als wichtiger Vertreter der Umweltpsychologie und Raumkognition. Beide halfen der Architektur, den Raum neu zu entdecken, wenn auch in unterschiedlichen Maßstäben und technologischen Kontexten. Lynch widmete sich den urbanen Räumen, arbeitete mit Karten, Gedächtnisprotokollen und Diagrammen; Miller hingegen erforschte die Räume des Lernens mit Lernmaschinen, Feedbacksystemen und digitalen Netzwerken.

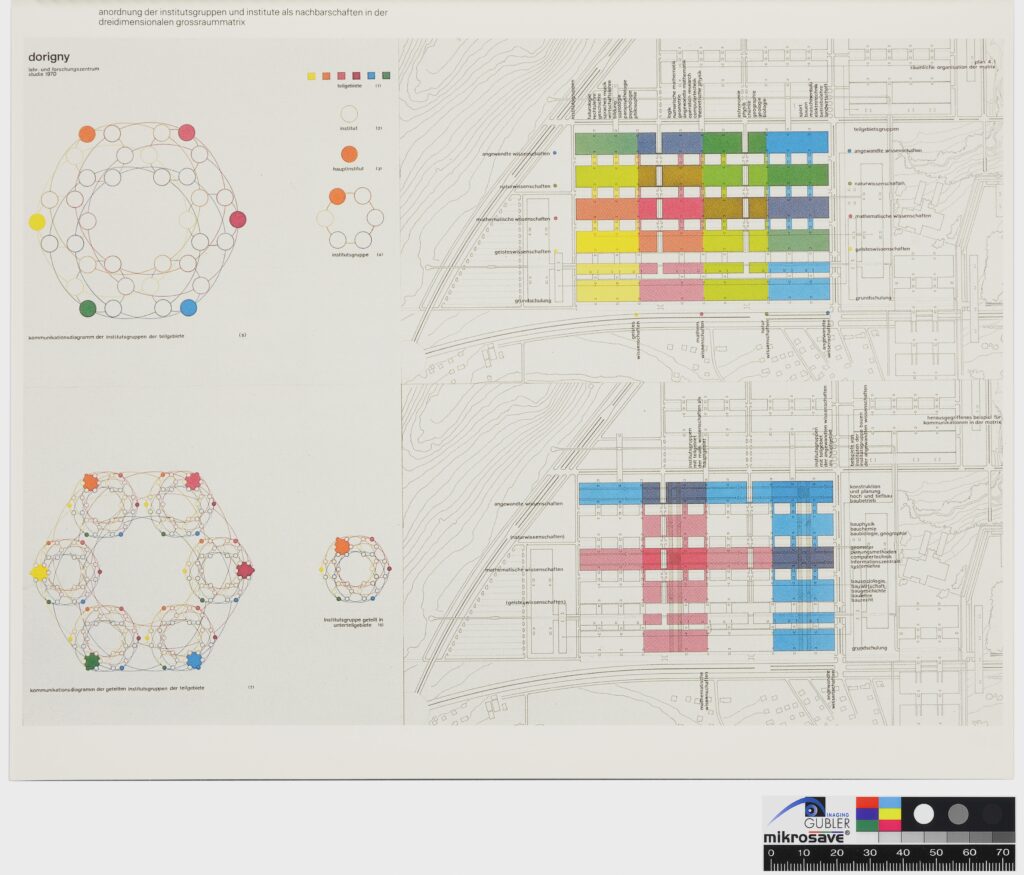

Bildungsreformer in Deutschland und der Schweiz griffen Millers Ideen auf – mit zeitlicher Verzögerung, aber ebenso ambitioniert. In Westdeutschland standen industrielle Schulbauten wie die Universitäten Bochum und Dortmund sinnbildlich für den Reformwillen der 1970er-Jahre. Hier versuchte man, das veraltete Bildungssystem radikal zu erneuern. Ernst Ulrich von Weizsäckers 1970 publiziertes Bildungsmanifest Baukasten gegen Systemzwänge[7] brachte die Idee modularer Lernstrukturen auf den Tisch, die forschendes Lernen und Interdisziplinarität stärken sollten. Amerikanische Vorbilder dienten als Inspiration, doch blieb das Konzept in der deutschen Bildungslandschaft verwurzelt. Während man in Westdeutschland noch in den Kategorien industrieller Bausysteme dachte, ging die Schweiz bereits einen Schritt weiter. Der Architekt Fritz Haller aus Solothurn hatte seit den 1950er-Jahren innovative Schul- und Hochschulbauten entworfen. Mit seinen USM-Haller-Bausystemen – modularen Strukturen, die auch international bekannt wurden – setzte er neue Maßstäbe.[8] Für den Wettbewerb eines neuen Universitätscampus der École Polytechnique Fédérale de Lausanne (EPFL) präsentierte Haller ein visionäres Projekt: Er verschob den Fokus von reinen Bausystemen hin zu einem technologischen Kommunikationsnetzwerk. Die Hochschule sei kein statisches Gebäude mehr, argumentierte er, sondern ein lebendiger Knotenpunkt in einem globalen Wissensnetzwerk – verknüpft durch Telefon, Fernsehen, digitale Datennetze und Hochgeschwindigkeitszüge, bereit für die Ära der Hochgeschwindigkeitskommunikation. Er wollte die Hochschulen zu offenen „Kulturzentren“ machen, die über den akademischen Diskurs hinaus auf die Gesellschaft ausstrahlten. Dieses Netzwerkdenken war das Herzstück von Hallers Vision. In den 1970er-Jahren arbeitete er zusammen mit Konrad Wachsmann an der University of Southern California in Los Angeles, wo er eine Grundlagenforschung für die Zukunft des Bauens entwickelte.

Haller identifizierte einen „allgemeinen Umwandlungstrend“ in der Architektur der Schulen, der sich in vier Stufen entfalten sollte: weg vom tradierten, hierarchischen Modell hin zu flachen Hierarchien. Zuerst, so Haller, würden die Schulleiter*innen überflüssig, dann auch die Lehrer*innen. Der klassische Frontalunterricht werde durch neue Formen des Team-Teaching und kollaborativen Lernens ersetzt. Am Ende dieses Trends stehe die Schule als offenes Netzwerk aus Menschen, Informationen und Maschinen – ein interdisziplinärer Knotenpunkt, der Lernen, Technologie und Gesellschaft verbindet, fast so, als hätte Haller Millers Vision in Architektur übersetzt. Jeder dieser Stufen ordnete Haller eine spezifische bauliche Struktur zu. Während sich die ersten drei Stufen an Hallers eigene Schulbauten anlehnen – wie die Kantonsschule Baden (1957–1964) und die Höhere Technische Lehranstalt Brugg-Windisch (1961–1966) –, ging er in der vierten Stufe noch weiter: Er entwarf eine Großraumschule als allseitig offenes System. Hier sollten Räume flexibel abgetrennt werden können, angepasst an die optischen, akustischen und klimatischen Anforderungen des Unterrichts. Hallers Vision war radikal, weil sie den Lernraum als adaptiven, vernetzten Organismus dachte, der sich ständig neu organisiert – ein Vorgriff auf die heutigen Konzepte von flexiblen Lernumgebungen und hybrider Lehre.

Ende der 1970er-Jahre war der Zenit visionärer Schulbauprojekte überschritten. Auch Fritz Hallers radikales Konzept der Netzwerkuniversität scheiterte. Das Preisgericht des Wettbewerbs hielt seine Ideen für zu progressiv, zu wenig praxisnah. Enttäuscht berichtete Haller der von Horst Rittel mitgegründeten Studiengruppe für Systemforschung in Heidelberg: „Die Experten nannten die Arbeit interessant, jedoch zu progressiv – zu unmenschlich – zu Un-Architektur. Vielleicht später einmal kann man so etwas bauen.“[9] Doch Haller blieb seiner Vision treu. Fast 30 Jahre später, im Jahr 1996 – kurz nach der Entstehung des World Wide Web am CERN – war er überzeugt: „Schulen werden nicht mehr Schulen sein. Sie sind Kommunikationsknoten eines globalen Netzwerks aus Beziehungen und Daten, in dem Menschen aller Wissensstände und sozialen Ränge agieren und neue Werte schaffen.“[10] Hallers Idee war ihrer Zeit voraus: ein Lernraum, der über den physischen Raum hinausgeht, sich in die digitale Vernetzung erstreckt und die Schule in ein dynamisches Zentrum globaler Wissensproduktion verwandelt.

Von der post-industriellen Gesellschaft, die traditionelle Fabriken durch wissensbasierte Ökonomien ersetzte, über die Netzwerkgesellschaft, die die Welt als komplexes Geflecht aus Verbindungen und Informationsströmen neu dachte, bis hin zur heutigen Datengesellschaft, geprägt von intelligenten Assistenzsystemen und künstlicher Intelligenz: Die Frage des Lernens ist aktueller denn je. Die kybernetische Vision – Lernen als Regelkreis aus Feedback und Anpassung – hat sich entfaltet und weiterentwickelt. Maschinen sind längst keine schweigsamen Geräte mehr; sie verwickeln uns in einen endlosen Dialog wie auf einer niemals endenden Cocktailparty, auf der wir unablässig in Gespräche vertieft sind, in denen ständig neue Fragen gestellt und unsere Gedanken auf neue Pfade gelenkt werden. Was einst als technokratisches Experiment begann, hat sich in eine offene Lernlandschaft verwandelt, in der Mensch und Maschine gemeinsam Wissen erzeugen.

Die Herausforderung liegt nun darin, diese dynamischen Lernumgebungen nicht nur anzunehmen, sondern kritisch zu hinterfragen – mit einem Bewusstsein für die Macht der Algorithmen und der Offenheit für die Chancen einer koevolutionären Zukunft des Lernens. Denn das Spiel hat sich gedreht: Es sind nicht mehr nur die Maschinen, die uns etwas beibringen. Maschinen unterrichten inzwischen Maschinen und wir befinden uns in einer seltsamen Doppelrolle – zugleich Lehrer*innen und Schüler*innen im Netz aus neuronalen Verbindungen, das wir selbst gespannt haben.

Der Mensch sieht sich mit einer glorreichen, aber auch diffusen Aufgabe konfrontiert: Die Kuratierung dieses intermaschinellen Lernprozesses. Statt lineare Bildungswege vorzugeben, stehen wir nun am Rand eines riesigen Wissensökosystems, in dem synthetische Daten, maschinelle Assistent*innen und menschliche Erfahrung miteinander verschmelzen.

Wir müssen neue Pädagogiken entwerfen, die nicht nur auf die Vermittlung statischer Inhalte abzielen, sondern das Fluktuieren des Wissens und die Konversationen zwischen Systemen verstehen. Es ist ein Lernen ohne festen Boden, ein Schweben zwischen Hypothesen, Datenpunkten und Mustern, die sich ständig ändern. Hier geht es weniger um die Kontrolle von Information als vielmehr um das Gestalten von Bedingungen, unter denen Wissen überhaupt entstehen kann.

In diesem Zeitalter der Konversationstechnologien werden wir also zu Vermittler*innen, zu Designer*innen neuer Formen des Lernens, in denen Daten nicht nur als Fakten betrachtet werden, sondern als narrative Elemente eines ständig wachsenden Dialogs. Vielleicht liegt hier die wahre Herausforderung und zugleich die große Verheißung unserer digitalen Gegenwart: eine neue Kultur des Lernens zu schaffen, die ebenso fließend, vernetzt und adaptiv ist wie die Technologien, die sie antreibt.

ist Professor für Architekturtheorie und digitale Kultur sowie der Leiter der Design, Data and Society Group an der Fakultät Architecture and the Built Environment der Technischen Universität Delft. Dort leitet er auch das interdisziplinäre Forschungsprojekt „The New Open“, das den Einfluss frei vetfügbarer Daten auf Design und sozialen Wandel erforscht. Georg Vrachliotis promovierte an der ETH Zürich und war von 2016 bis 2020 Dekan der Fakultät für Architektur und Professor für Architekturtheorie mit dem Schwerpunkt digitale Kultur am Karlsruhe Institute of Technology (KIT). Im Verlauf seiner Karriere kuratierte Georg Vrachliotis mehrere Ausstellungen, darunter im Schweizerischen Architekturmuseum in Basel Fritz Haller. Architekt und Forscher (mit Laurent Stalder, 2014), Sleeping Beauty: Reinventing Frei Ottos Multihalle auf der Architekturbiennale in Venedig (mit Sally Bellow, 2018) sowie Models, Media and Methods: Frei Otto’s Architectural Research an der Architekturfakultät der Universität Yale (2020). Er ist der Autor und Co-Autor mehrerer Bücher, etwa The New Technological Condition (2022), ist Mitglied des Beirats der renommierten Zeitschrift ARCH+ und externer Prüfer an der Bartlett School of Architecture, UCL London.